Vzhledem k tomu, že se rozruch rozptyluje kolem Depaseeka, organizace se ptá na různé otázky týkající se používání generativní AI na pracovišti. Konkrétně, pokud je DePeek specifickou hrozbou pro bezpečnost nebo pokud jednoduše ukazuje rizika související s rozšířením používání chatbotů umělé inteligence a modelů velkých jazyků (LLM). Odpověď, jako obvykle, je ve středu.

Přestože čínský chatbot může mít své vlastní problémy s soukromí, zabezpečení a cenzury, není to jediný. Všechny modely generativní a LLM znamenají rizika, zejména pokud neexistuje plné povědomí o tom, jak často, kde a proč jsou používány.

S těmito nástroji, které vyžadují více než webový prohlížeč, je stále obtížnější pochopit typy informací, které jsou odesílany a přijímány mezi lidmi a aplikacemi. Pokud nás Deepseekův rychlý vzestup může něco naučit, je to rychlost, s jakou mohou výkonné aplikace dosáhnout trhu a dosáhnout zobecněného adopce. V případě, že ovládací prvky nejsou dostatečně rychlé, aby udržely krok, se rizika, která fungují ve stínu, zvyšují.

Co se stane ve stínu?

AI ve stínu odkazuje na použití jakéhokoli nástroje mimo kontrolu a povolení organizace, často bez jejího vědomí. Zatímco někteří zaměstnanci úmyslně maskují používání těchto aplikací, mnoho dalších je používá otevřeně a v dobré víře, aniž by si byli vědomi rizik nebo zda používají generativní.

Pokud je průměrný zaměstnanec dotázán na aplikace AI, které používá denně, může odpovědět na chatgpt. Přesto existuje mnoho běžnějších: od Copilot de Microsoft a Gemini z Google po Claude, Gramatiky, Otter a některé nástroje Canva a GitHub.

Tyto aplikace nabízejí mnoho výhod a pomáhají zaměstnancům pracovat rychleji a efektivněji, ačkoli je nezbytné vědět, co s nimi zaměstnanci sdílejí a že ti, kteří je používají, vědí, jak pracují, jak zvládají data a mnoho potenciálních rizik, která představují organizaci.

To, co nevíte, je, jestli vám mohou ublížit

Jak se očekávalo, jakmile Deepseek přitahoval pozornost světa, stal se cílem kybernetických zločinů; A je to, že jakákoli aplikace, která ukládá a analyzuje data, je v pohledu útočníků. Pokud uživatel neovládá použití tohoto typu nástrojů, je nepravděpodobné, že zjistíte, kolik jejich dat je na vašich datech, než bude příliš pozdě.

Toto jsou některá z četných rizik, kterým AI ve stínu odhaluje:

- Zranitelnosti zabezpečení: Když jsou informace sdíleny s neoprávněnou třetí stranou, neexistuje způsob, jak zjistit, jak je uložen, zpracováván nebo analyzován. Něco tak neškodného, jako je žádost LLM, aby připravil e -mail pro zákazníka nebo shrnul přepis hovoru, může odhalit důvěrná data o společnosti a jejích zákaznících.

- Integrita dat: AI dělá chyby; A když profesionál používá k dopisu ChatGPT a další nástroje, riskuje, že udělí autentičnost nesprávným informacím, které mohou ovlivnit jejich služby a poškodit jejich pověst.

- Dodržování: Kromě toho, že údaje ohrožují riziko expozice, by sdílení informací s aplikacemi AI ve stínu mohlo ohrozit dohody o důvěrnosti, GDPR a další další předpisy o ochraně osobních údajů.

- Vnitřní hrozby: Uživatelé, kteří kopírují a lepí kód, text nebo obrázky neoprávněných nástrojů, mohou ve svých systémech a sítích zavést zranitelnosti, malware a další prvky.

- Důvěra a spolehlivost: Použití stínových služeb může být v rozporu s veřejnou politikou ohledně tohoto typu nástrojů, což způsobuje problémy důvěry a autentičnosti v případě, že zákazníci, současný nebo potenciál a partneři zjistí.

Stínová zabezpečení

Neexistuje žádné zázračné řešení pro ochranu používání AI ve stínu. Veškerý efektivní kybernetický oheň musí mít několik úrovní a kombinovat lidi, procesy a technologii. To znamená použití ovládacích prvků přístupu a údajů zaměřených na uživatele, spolu s solidními interními zásadami a tipy pro správu IA pro dohled a vedení.

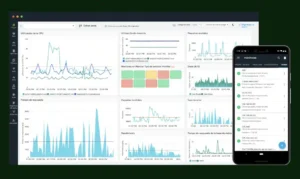

Se specializovanými nástroji DLP lze vysledovat použití více než 600 generativních webů na uživatele, skupinu nebo oddělení; Identifikovat každého, kdo má přístup k datům v cloudu, e -mailu a kalendářích; a dohlížet na používání aplikací v kontextu s rizikem uživatele.

Komplexní řešení umožňuje aplikovat přijatelné zásady pro použití generativních, blokováním zatížení nebo přilepených citlivých dat, psaní citlivých podmínek indikací AI a zachycení metadat a snímků obrazovky před a po použití generativních aplikací.

Tyto ovládací prvky musí být doprovázeny solidním a nepřetržitým tréninkem, aby se zvýšilo povědomí. Všichni členové organizace musí znát potenciální rizika spojená s AI ve stínu a také procesy schválené pro vyžádání a používání nových technologií.

Mít řešení, jak udržet krok s generativními nástroji AI, architektonický přístup, umožní rychle inovovat a zobrazovat nové kapacity s minimálním dopadem na produktivitu uživatele.

Tímto způsobem, co potřebuje dělat svou práci, lze zaměstnancům poskytnout, aniž by ve stínu ztratili důvěrná data.

Autor: Manuela Muñoz, senior jmenovaný správce účtu v ProofPoint

Čerpáme z těchto zdrojů: google.com, science.org, newatlas.com, wired.com, pixabay.com