Nové technologie neustále mění bezpečnostní prostředí, ale jen málo z nich má pravděpodobně transformační sílu generativní umělé inteligence. Vzhledem k tomu, že platformy jako ChatGPT stále získávají na síle, musí CISO pochopit bezprecedentní rizika kybernetické bezpečnosti, která přinášejí, a co s nimi dělat.

„Narušující“ část převratných inovací často pochází z nezamýšlených důsledků, které s tím přicházejí. Tiskárna usnadnila kopírování textů, ale změnila tím sociální, politickou, ekonomickou a náboženskou strukturu Evropy. Revolucí v lidské mobilitě automobil přetvořil uspořádání komunit a dal vzniknout předměstím a automobilové kultuře 20. století. V poslední době World Wide Web zcela změnil způsob, jakým se lidé navzájem spojují a přistupují k informacím, a přeformuloval otázky, jako je soukromí, geopolitické hranice a svoboda projevu.

Zdá se, že generativní umělá inteligence bude stejně transformativní jako všechny ostatní, přičemž skvělé jazykové modely jako ChatGPT a Google Bard a generátory obrázků jako DALL-E vzbudily během několika měsíců obrovský zájem.

Vzhledem k rychlému přijetí těchto nástrojů potřebují CISO naléhavě porozumět souvisejícím rizikům kybernetické bezpečnosti a tomu, jak se tato rizika radikálně liší od předchozích.

bující adopce

Říci, že společnosti jsou nadšené z možností generativní umělé inteligence, je slabé slovo. Podle Studie, pouhých šest měsíců po veřejném spuštění ChatGPT uvedlo 49 % společností, že jej již používají, 30 % ho plánuje používat a 93 % prvních uživatelů ho zamýšlelo používat více.

K čemu to je? Pro vše od navrhování dokumentů a generování počítačového kódu až po provádění interakcí se zákaznickým servisem. A to je jen začátek toho, co přijde. Zastánci tvrdí, že umělá inteligence pomůže vyřešit složité problémy, jako je změna klimatu a zlepšit lidské zdraví, například urychlením pracovních postupů v radiologii a zpřesněním výsledků rentgenových, CT a MRI (MRI), přičemž zlepší výsledky s menším počtem falešně pozitivních výsledků. .

Všechny nové technologie však s sebou nesou rizika, jako jsou nové zranitelnosti a způsoby útoků. Uprostřed veškerého hluku a zmatku kolem dnešní umělé inteligence jsou tato rizika stále špatně pochopena.

Čím se generativní AI liší?

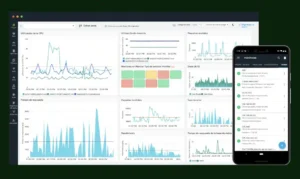

Strojové učení (ML) a rané formy umělé inteligence jsou tu s námi již nějakou dobu. Autonomní auta, obchodní systémy, logistická řešení atd. jsou dnes poháněny nějakou kombinací ML a AI. V bezpečnostních řešeních, jako je XDR, ML identifikuje vzorce a porovnává chování, takže anomálie jsou lépe detekovatelné. Umělá inteligence funguje jako hlídací pes, monitoruje aktivitu a detekuje potenciální hrozby na základě analýzy toho, co se zdá být normální nebo neohrožující, prováděné ML, a v případě potřeby spouští automatické reakce.

Ale ML a jednodušší formy umělé inteligence jsou nakonec omezeny na práci s daty, která do nich byla vložena. Generativní umělá inteligence se liší v tom, že její algoritmy nejsou nutně pevné nebo statické, jak je tomu často v případě ML: často se neustále vyvíjejí, čerpají z minulých „zkušeností“ systému jako součást jeho učení a umožňují mu vytvářet zcela nové informace. .

Kyberzločinci se až dosud ML a dalším omezenějším formám umělé inteligence většinou vyhýbali, protože jejich výsledky nejsou pro zneužívání nijak zvlášť cenné. Ale výkon ML pro zpracování dat s kreativitou generativní umělé inteligence z něj dělá mnohem působivější nástroj útoku.

Generativní bezpečnostní rizika AI: klíčové otázky

S kým to vlastně mluvíš?

Britský matematik a počítačový vědec Alan Turing vymyslel v 50. letech test, aby zjistil, zda lze dostatečně pokročilý počítač zaměnit v konverzaci v přirozeném jazyce za člověka. Systém umělé inteligence LaMDA společnosti Google tímto testem prošla v roce 2022 a upozornila na jeden z hlavních bezpečnostních problémů s generativní AI, konkrétně na její schopnost napodobovat lidskou komunikaci.

Tato schopnost z něj dělá mocný nástroj pro phishingová schémata, která až dosud spoléhala na falešné zprávy často plné překlepů. Naproti tomu phishingové texty a e-maily vytvořené umělou inteligencí jsou vylepšené a bez chyb a mohou dokonce emulovat známého odesílatele, například generálního ředitele společnosti, který dává pokyny svému týmu. Pokročilé technologie deep fake to posunou o krok dále se svou schopností napodobovat tváře a hlasy lidí a vytvářet celé „scény“, které se nikdy nestaly.

Generativní umělá inteligence to dokáže nejen na individuální bázi, ale také ve velkém měřítku, interaguje s mnoha různými uživateli současně pro maximální efektivitu a potenciál pronikání. A za těmito phishingovými schématy by mohl být škodlivý kód generovaný také programy AI pro použití při kybernetických útocích.

Kdo vlastní vaše informace?

Mnoho společností skočilo do rozjetého vlaku AI chatbotů, aniž by plně zvážily důsledky pro jejich firemní data, zejména pokud jde o citlivé informace, tajemství konkurentů nebo záznamy regulované zákony na ochranu soukromí. Ve skutečnosti v současné době neexistuje žádná jasná ochrana citlivých informací vkládaných do veřejných platforem umělé inteligence, ať už se jedná o osobní zdravotní údaje poskytované k naplánování lékařské prohlídky nebo soukromé firemní informace procházející chatbotem za účelem vytvoření marketingové brožury.

Příspěvky do veřejného chatbota s umělou inteligencí se stávají součástí platformy a mohou být použity v budoucích školicích kurzech. I když je toto školení moderováno lidmi a chráněno soukromím, konverzace mají stále potenciál „žít“ i po počátečním sdílení, což znamená, že společnosti nemají plnou kontrolu nad svými daty, jakmile jsou sdíleny.

Dá se věřit tomu, co říká generativní AI?

Ukázalo se, že AI chatboti jsou náchylní k takzvaným halucinacím, které generují falešné informace. Novináři z The New York Times se zeptali ChatGPT, kdy jejich noviny poprvé informovaly o umělé inteligenci, a platforma vykouzlila článek z roku 1956 – titulek a všechno –, který nikdy neexistoval. Spoléhat se na výsledky umělé inteligence a sdílet je se zákazníky, partnery nebo veřejností nebo na nich vytvářet obchodní strategie je pro společnosti jednoznačně strategickým rizikem a rizikem reputace.

Stejně znepokojivá je náchylnost generativní umělé inteligence k dezinformacím. Všechny platformy umělé inteligence jsou školeny na souborech dat, takže integrita dat je kritická. Vývojáři stále častěji využívají živý internet v reálném čase jako neustále aktualizovaný soubor dat, čímž vystavují programy umělé inteligence riziku, že budou vystaveny dezinformacím, ať už nevinně nesprávným, nebo zlomyslně zmanipulovaným za účelem zkreslení výsledků umělé inteligence, což by mohlo způsobit bezpečnostní rizika.

Co lze dělat proti bezpečnostním rizikům generativní umělé inteligence?

Mnoho bezpečnostních společností plánuje použít AI k boji proti ní a vyvíjí software, který rozpoznává phishingové podvody generované AI, hluboké padělky a další nepravdivé informace. Tyto typy nástrojů budou v budoucnu stále důležitější.

Společnosti však musí zajistit svou vlastní bdělost, zejména proto, že generativní umělá inteligence může narušit tradiční informační sila, která uchovávají informace pasivně chráněné. Zatímco cloud poskytl společnostem něco jako simulakrum pro vypořádání se s odpovědností distribuovaných dat a otevřených systémů, generativní umělá inteligence zavádí nové úrovně složitosti, které je třeba řešit kombinací technologických nástrojů a informovaných zásad.

Představte si například společnost, která v minulosti uchovávala informace o svých zákaznických platebních kartách (PCI) odděleně od jiných datových souborů. Pokud někdo ve společnosti používá veřejnou platformu umělé inteligence k identifikaci příležitostí růstu prodeje na základě minulých vzorců výdajů zákazníků, tato data PCI by se mohla stát součástí znalostní základny AI a objevit se na jiných místech.

Jedním z nejdůležitějších kroků, které může společnost podniknout, aby se ochránila, je vyhnout se domněnce, že vzhledem k tomu, že nevlastní nástroje umělé inteligence ani je neoprávňuje k jejich používání, není ohrožena. Zaměstnanci, partneři a zákazníci mohou používat veřejné platformy AI a vědomě či nevědomě je krmit potenciálně kompromitujícími podnikovými informacemi.

Je jasné, že generativní umělá inteligence přináší z hlediska kybernetické bezpečnosti hodně věcí, které je třeba zvážit, a jsme teprve na začátku, kam nás tato nová technologie zavede.

Čerpáme z těchto zdrojů: google.com, science.org, newatlas.com, wired.com, pixabay.com